Bulan Mei 2020 yang lalu, saya pernah menuliskan efek perubahan algoritma SEO May 2020 Core Update. Ketika itu dampak perubahan anomali trafik, baik yang meningkat atau menurun, turut dirasakan oleh beberapa web dengan kategori tertentu. Sayangnya, tidak ada informasi resmi dan mendetail dari Google, algoritma apa saja yang sebetulnya sedang dijalankan ketika itu.

Later today, we are releasing a broad core algorithm update, as we do several times per year. It is called the December 2020 Core Update. Our guidance about such updates remains as we’ve covered before. Please see this blog post for more about that:https://t.co/e5ZQUAlt0G

— Google SearchLiaison (@searchliaison) December 3, 2020

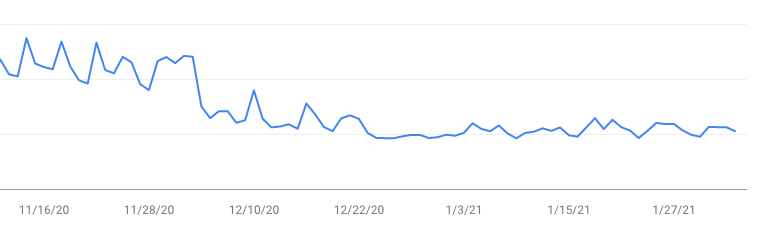

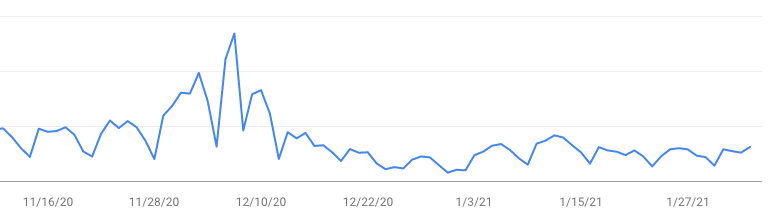

Bulan Desember 2020 yang lalu, Google juga kembali mengumukan update core terbaru yang disebut December 2020 Core Update. Setelah diamati dalam kurun waktu sebulan setelah update tersebut dirilis, beberapa web yang saya kelola ternyata juga kena dampaknya.

Saya coba cek beberapa web yang dikelola oleh orang lain juga mengalami hal serupa, meskipun tidak semuanya. Bahkan beberapa web tersebut punya kecenderungan yang justru berkebalikan, trafiknya lebih tinggi ketimbang bulan sebelumnya, meskipun dengan treatment yang sama.

Jika dampaknya membuat web tersebut meningkat sih oke-oke saja dan nggak ada masalah. Nah, yang bikin kecewa adalah jika web tersebut tiba-tiba turun, kemudian tak kunjung naik seperti semula. Tentu perubahan ini akan mengakibatkan jumlah trafik rata-rata dalam sebulan bisa berkurang drastis dibandingkan bulan sebelumnya.

Salah satu web yang getol mengulas soal SEO, Searchmetrics, mengungkap web apa saja yang terkena dampak kenaikan dan penurunan trafik, termasuk membandingkannya dengan anomali yang terjadi pada May 2020 Core Update. Meskipun analisis tersebut hanya membahas web-web yang cukup populer di US, pada kenyataannya algoritma tersebut juga dirasakan oleh web-web yang dihosting di luar US.

Berikut adalah hasil tangkapan layar Google Search Console yang saya ambil dari dua web berbeda. Keduanya memiliki kecenderungan yang sama, yakni memiliki kecenderungan turun setelah tanggal 3 Desember 2020.

Dari beberapa sumber yang saya baca, pengumuman dari Google ini lagi-lagi juga tidak menunjukkan kejelasan. Misalnya, jenis web seperti apa yang akan terdampak oleh perubahan algoritma tersebut.

Google hanya memaparkan semacam pesan atau kisi-kisi web seperti apa di masa depan yang akan lebih mudah diindeks pada pencarian Google. Lalu apa isi pesan yang disampaikan oleh Google?

Beberapa kali Google selalu menggunakan kalimat yang hampir sama yaitu ‘improve your content over time’. Artinya Google mengingkinkan kualitas konten yang ada di situsweb harus selalu ditingkatkan guna memenuhi standar algoritma PageRank yang selama ini masih dipakai Google.

Google juga menjamin bahwa selama konten yang dimuat oleh sebuah web itu lebih user-friendly (merujuk pada bagaimana konten tersebut nyaman dibaca/dilihat oleh pengguna terutama pada perangkat mobile), sekaligus unik dibanding kompetitornya, maka perlahan-lahan konten tersebut akan segera diindeks ulang posisinya untuk mendapatkan ranking yang lebih baik di pencarian.

Jadi, untuk sementara ini, solusi untuk mengatasi web-web yang terkena dampak penurunan trafik tersebut yaitu untuk terus membuat konten-konten yang unik, menarik bagi pembaca, tak perlu takut dengan konten artikel yang terlalu panjang, serta bisa dibaca melalui perangkat mobile dengan nyaman.

Algoritma BERT vs SMITH

Pada tahun 2020, Google sempat memperkenalkan istilah-istilah algoritma seperti BERT (Bidirectional Encoder Representations from Transformers), kemudian SMITH (Siamese Multi-depth Transformer-based Hierarchical). Kedua algoritma tersebut diharapkan bisa membantu mesin pencari untuk menemukan konteks yang lebih relevan atas kata kunci yang dimasukkan oleh user pada kolom pencarian.

Pada dasarnya, algoritma BERT adalah sebuah model yang digunakan untuk mengenali kata-kata berdasarkan konteks pada sebuah kalimat. Namun, model ini punya keterbatasan, yaitu hanya bisa digunakan untuk artikel-artikel yang pendek, kurang lebih sekitar 512 kata.

Sementara itu, algoritma SMITH dikembangkan untuk mengatasi keterbatasan pada algoritma BERT dan konon bisa memberikan hasil yang lebih memuaskan. Algoritma SMITH bisa mengenali bagian utama atau paragraf inti (main passage) dari sebuah tulisan yang panjang (kurang lebih 2048 kata).

Ini bukan pekerjaan yang mudah karena selain harus diterapkan pada artikel-artikel yang lebih panjang (long-form), algoritma SMITH juga harus bisa mengenali struktur tulisan dari sebuah dokumen sehingga memerlukan lebih banyak memori untuk menentukan bagian mana yang akan diambil sebagai main passage.

Menurut beberapa sumber, sejauh ini algoritma SMITH belum diimplementasikan ke dalam algoritma yang dipakai mesin pencari Google. Bila melihat kiprah algoritma SEO, saya masih berpikiran positif. Mungkin Google sedang melakukan uji coba algoritma tersebut untuk mendapatkan insight yang lebih realistis dan semakin relevan.